Modéliser, déployer, orchestrer et optimiser les applications et les infrastructures du cloud

— Aperçu

Stratégie basée sur une abstraction significative de la description de la structure de l’application afin de pouvoir automatiser encore plus la gestion des applications et des infrastructures.

Christian Perez, Directeur de recherche Inria

Mots-Clés : Cloud, Edge, IoT, Computation Continuum, modèle, vérification, déploiement, reconfiguration, orchestrateur, optimisation

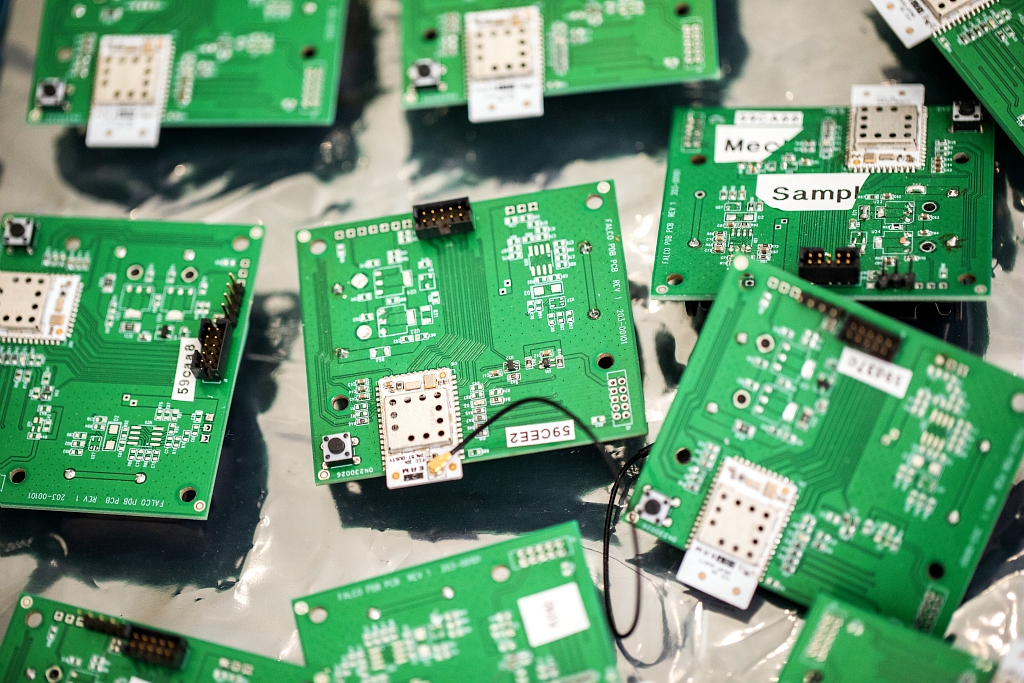

Les nouvelles infrastructures, telles que le Edge Computing ou le continuum de calcul Cloud-Edge-IoT, rendent les problématiques du cloud plus encore complexes car elles ajoutent de nouvelles problématiques liées à la diversité et à l’hétérogénéité des ressources (du petit capteur au centre de données / HPC, du réseau à basse consommation aux réseaux de cœur), à la distribution géographique, ainsi qu’à des besoins accrus de dynamicité et de sûreté, le tout sous des contraintes comme par exemple de consommation d’énergie.

Pour exploiter efficacement ces nouvelles infrastructures, le projet Taranis est basé sur une stratégie visant à abstraire la description de la structure des applications et des ressources afin d’automatiser encore plus leur gestion. Ainsi, il sera possible d’optimiser globalement les ressources utilisées vis à vis d’objectifs multicritères (prix, échéance, performance, énergie, etc.) aussi bien du côté utilisateur (applications) que fournisseur de ressources (infrastructures). Taranis vise aussi les défis liés à l’abstraction de la reconfiguration des applications et afin d’adapter dynamiquement l’usage des ressources.

— Les missions

— Nos recherches

Le projet Taranis aborde cette problématique via quatre lots scientifiques, chacun se focalisant sur une phase du cycle de vie des applications : modèle de description des applications et infrastructures, déploiement et reconfiguration, orchestration et optimisation. Le lot 0 est consacré à la gestion de projet.

— Les partenaires

Le consortium

Inria, CNRS, IMT, UGA, CEA, Université de Rennes, ENS Lyon, Université Claude Bernard Lyon 1, Université de Lille, INSA Rennes

Implantation des équipes en France

— Les publications

Articles dans une revue

- Fatima Elhattab, Sara Bouchenak, Cédric Boscher. PASTEL: Privacy-Preserving Federated Learning in Edge Computing. Proceedings of the ACM on Interactive, Mobile, Wearable and Ubiquitous Technologies , 2024, 7 (4), pp.1-29. ⟨10.1145/3633808⟩. ⟨hal-04394133⟩

Communications dans un congrès

- Brell Sanwouo, Paul Temple, Clément Quinton. Dynamic Agent Generation for Self-Adaptive Root Cause Analysis. SEAMS'26 - 21st International Conference on Software Engineering for Adaptive and Self-Managing Systems, Apr 2026, Rio de Janeiro, Brazil. ⟨hal-05402186⟩

- Pierre Bourhis, Cristian Riveros, Amaranta Salas. A formal query language and automata model for aggregation in complex event recognition. ICDT 2026 - 29th International Conference on Database Theory, Mar 2026, Tampere, Finland. ⟨hal-05482197⟩

- Martin Molli, Daniel Balouek, Paul Temple, Thomas Ledoux. Event-Driven Adaptation in the Computing Continuum Using Software Variability. UCC 2025 - IEEE/ACM 18th International Conference on Utility and Cloud Computing, Dec 2025, Nantes, France. pp.1-2, ⟨10.1145/3773274.3774672⟩. ⟨hal-05379151⟩

- Danny de Novi, Lorenzo Carnevale, Daniel Balouek-Thomert, Manish Parashar, Massimo Villari. Predictive Resource Management in the Computing Continuum: Transfer Learning from Virtual Machines to Containers using Transformers. UCC 2025 - IEEE/ACM 18th International Conference on Utility and Cloud Computing, Dec 2025, Nantes, France. pp.1-8, ⟨10.1145/3773274.3774856⟩. ⟨hal-05468841⟩

- Wided Meflah, Hayet Brabra, Mehdi Acheli, Hosni Ben Douma, Mohamed Sellami, et al.. From natural language to TOSCA: leveraging LLMs for automated service composition. International Conference on Service-Oriented Computing (ICSOC), Dec 2025, Shenzen, China. pp.3-18, ⟨10.1007/978-981-95-5012-8_1⟩. ⟨hal-05456614⟩

- Philippe Merle, Fabio Petrillo. Visualizing Cloud-native Applications with KubeDiagrams. VISSOFT 2025 - 13th IEEE Working Conference on Software Visualization, Sep 2025, Auckland, New Zealand. pp.106 - 116, ⟨10.1109/VISSOFT67405.2025.00022⟩. ⟨hal-05263068⟩

- Brell Sanwouo, Paul Temple, Clément Quinton. Generative AI-based Adaptation in Microservices Architectures: A Systematic Mapping Study. ICWS'25 - International Conference on Web Services, Jul 2025, Helsinki, Finland. pp.1-8. ⟨hal-05082732v2⟩

- Martin Molli, Daniel Balouek, Paul Temple, Thomas Ledoux. Facilitating Heterogeneity Management on the Computing Continuum. COMPAS 2025 - Conférence francophone d'informatique en Parallélisme, Architecture et Système, Jun 2025, Bordeaux, France. pp.1-8. ⟨hal-05138189⟩

- Nawel Benarba, Mathieu Chevalier, Sara Bouchenak, Benjamin Bertin, Olivier Jung. Anomaly Detection in Energy Performance Certificates – From Oblivious to Enlightened. 2025 55th Annual IEEE/IFIP International Conference on Dependable Systems and Networks - Supplemental Volume (DSN-S), Jun 2025, Naples, Italy. pp.8-14, ⟨10.1109/DSN-S65789.2025.00035⟩. ⟨hal-05252374⟩

- Brell Peclard Sanwouo, Clément Quinton, Paul Temple. Breaking the Loop: AWARE is the new MAPE-K. FSE'25 - ACM International Conference on the Foundations of Software Engineering, Jun 2025, Trondheim, Norway. pp.626-630, ⟨10.1145/3696630.3728512⟩. ⟨hal-04992342⟩

- Dominik Huber, Sergio Iserte, Martin Schreiber, Antonio J. Peña, Martin Schulz. Bridging the Gap Between Genericity and Programmability of Dynamic Resources in HPC. ISC High Performance 2025 - 40th ISC High Performance International Conference, Jun 2025, Hamburg, Germany. pp.1-11. ⟨hal-04994828⟩

- Cédric Boscher, Nawel Benarba, Fatima Elhattab, Sara Bouchenak. Personalized Privacy-Preserving Federated Learning. Proceedings of the 25th International Middleware Conference, Dec 2024, Hong Kong, China. pp.454--466, ⟨10.1145/3652892.3700785⟩. ⟨hal-04770214⟩

- Yasmine Djebrouni, Isabelly Rocha, Sara Bouchenak, Lydia Chen, Pascal Felber, et al.. Characterizing Distributed Machine Learning Workloads on Apache Spark. Middleware '23: 24th International Middleware Conference, Dec 2023, Bologna, Italy. pp.151-164, ⟨10.1145/3590140.3629112⟩. ⟨hal-04399409⟩

Autres publications

- Yasmine Djebrouni, Vania Marangozova, Sara Bouchenak. Dataset for Characterizing Distributed Machine Learning Workloads on Apache Spark. 2024, ⟨10.5281/zenodo.14151075⟩. ⟨hal-04781721⟩

Autres projets